PyTorch数据处理 torch.utils.data模块的7个核心函数详解

在深度学习中,数据处理是模型训练和评估的关键环节。PyTorch作为一个流行的深度学习框架,提供了强大而灵活的数据处理工具,其中torch.utils.data模块是核心。它允许我们高效地加载、预处理和批处理数据,从而简化了训练流程。本文将详细介绍torch.utils.data模块中最重要的7个核心函数及其用法,帮助您掌握PyTorch数据处理的精髓。

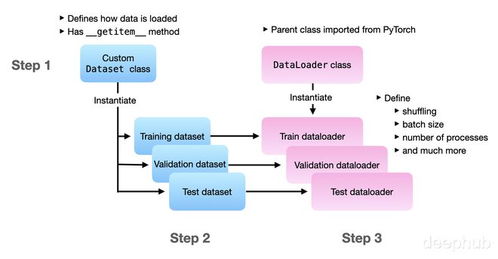

1. Dataset

Dataset是一个抽象类,是所有自定义数据集的基础。它定义了如何获取单个数据样本及其标签。您需要继承Dataset并实现两个方法:

<strong>len</strong>(): 返回数据集中的样本总数。<strong>getitem</strong>(idx): 根据索引idx返回对应的样本(例如,图像和标签)。

示例代码:`python

from torch.utils.data import Dataset

class CustomDataset(Dataset):

def init(self, data, labels):

self.data = data

self.labels = labels

def len(self):

return len(self.data)

def getitem(self, idx):

return self.data[idx], self.labels[idx]`

2. DataLoader

DataLoader是数据加载的核心工具,它将Dataset包装成一个可迭代对象,支持自动批处理、打乱数据和多进程加载。主要参数包括:

dataset: 要加载的数据集对象。batch_size: 每个批次的大小。shuffle: 是否在每个epoch打乱数据。num_workers: 用于数据加载的子进程数。

示例代码:`python

from torch.utils.data import DataLoader

dataloader = DataLoader(dataset, batchsize=32, shuffle=True, numworkers=4)

for batchdata, batchlabels in dataloader:

# 训练代码

`

3. random_split

random_split用于将数据集随机分割为多个子集,常用于划分训练集、验证集和测试集。它接受一个数据集和子集长度的列表,返回多个Subset对象。

示例代码:`python

from torch.utils.data import random_split

trainsize = int(0.8 * len(dataset))

valsize = len(dataset) - trainsize

traindataset, valdataset = randomsplit(dataset, [trainsize, valsize])`

4. Subset

Subset用于创建数据集的子集,通常与random_split结合使用。它接受一个数据集和索引列表,返回包含指定索引样本的子集。

示例代码:`python

from torch.utils.data import Subset

indices = [0, 2, 4] # 选择索引为0, 2, 4的样本

subset = Subset(dataset, indices)`

5. ConcatDataset

ConcatDataset用于合并多个数据集,创建一个更大的数据集。这在处理来自不同来源的数据时非常有用。

示例代码:`python

from torch.utils.data import ConcatDataset

combined_dataset = ConcatDataset([dataset1, dataset2])`

6. WeightedRandomSampler

WeightedRandomSampler是一个采样器,允许根据权重随机采样数据。这对于处理类别不平衡的数据集特别有用,可以为少数类样本分配更高的权重。

示例代码:`python

from torch.utils.data import WeightedRandomSampler

weights = [0.1, 0.9] # 假设两个类别的权重

sampler = WeightedRandomSampler(weights, numsamples=100, replacement=True)

dataloader = DataLoader(dataset, batchsize=32, sampler=sampler)`

7. default_collate

default<em>collate是一个函数,用于将多个样本组合成一个批次。DataLoader默认使用它来处理批处理。如果您有特殊的数据结构(如变长序列),可以自定义collate</em>fn来覆盖默认行为。

示例代码:`python

from torch.utils.data.dataloader import default_collate

def custom_collate(batch):

# 自定义批处理逻辑

return default_collate(batch)

dataloader = DataLoader(dataset, batchsize=32, collatefn=custom_collate)`

###

通过掌握这7个核心函数,您可以高效地处理各种数据场景,从简单的数据集加载到复杂的批处理和采样策略。torch.utils.data模块的设计强调灵活性和可扩展性,使得PyTorch在数据处理方面表现出色。建议在实际项目中多练习这些函数,结合具体需求进行定制化,以提升深度学习工作流的效率。

无论是构建自定义数据集、划分训练验证集,还是处理不平衡数据,这些工具都能为您提供强大的支持。随着PyTorch版本的更新,该模块可能会引入更多功能,因此建议关注官方文档以获取最新信息。

如若转载,请注明出处:http://www.zzzcvip.com/product/68.html

更新时间:2026-02-25 17:41:46